Coloquio: Optimal Control Theory and Quantum Information Systems

- 2025-07-17 14:00 |

- Aula Federman

*Por Pablo Mininni

El último 19 de noviembre una de las presentaciones orales mas anticipadas de la reunión anual de la División de Fluidos de la Asociación Americana de Física apareció en diarios y revistas del espectáculo. Los organizadores de la reunión, a la que asisten cada año más de tres mil personas, no pudieron conseguir para esta presentación un recinto lo suficientemente grande y el público se acumuló en las puertas.

La charla tenía un título -como menos- llamativo: “Ant-Man and The Wasp: Helping Marvel superheroes breathe”. Ant-Man es un superhéroe de Marvel que puede encogerse al tamaño de una hormiga, o crecer por encima de los treinta metros de altura y convertirse en un Goliat. Creado por los legendarios Stan Lee, Larry Lieber y Jack Kirby en 1962, alcanzó la fama fuera del mundo de los cómics en dos películas recientes de Marvel Studios. The Wasp (la avispa), creada solo un año después, es su versión femenina y en los cómics es una de las fundadoras originales de Los Vengadores. Y aunque el interés de la prensa del espectáculo por estos temas puede ser entendible -las películas de superhéroes pueden facturar mas de 500 millones de dólares-, el interés que despertó esta charla y un paper reciente de los mismos autores es un fenómeno propio de otro universo.

Mientras Ant-Man y The Wasp reducen su tamaño utilizando un traje especial -y unas muy dudosas partículas fundamentales no descubiertas por el momento-, mantienen su masa y su fuerza original. Y aunque el cambio de tamaño podría ser motivo más que suficiente para dudar sobre la verosimilitud científica de toda la historia, los autores de este paper consideraron desde el punto de vista físico los problemas que estos cambios pueden generar a los cuerpos de quienes utilizan los trajes.

El trabajo fue publicado en 2018 en una revista cuyo nombre es de por sí gracioso: A. Staples y M. Mikel-Stites. "Ant-Man and The Wasp: Microscale respiration and microfluidic technology”. Superhero Science & Technology 1, 2018 (DOI: 10.24413/SST.2018.1.2474) https://journals.open.tudelft.nl/index.php/superhero/article/view/2474

Para cerrar este año 2018, y como lectura ligera para iniciar el verano, les recomiendo una mirada a este trabajo. Cada cual puede tener sus propias razones: conocer algo sobre la física de los superhéroes, un tema que es cada vez más usado para despertar vocaciones por la ciencia en los adolescentes; satisfacer una curiosidad (¡o algún gusto culposo!) por personajes que se visten con su ropa interior por encima de sus pantalone; poder comentar a sus amigos que en otros países del mundo los científicos también dedican parte de su tiempo a pensar estupideces; o simplemente, divertirse un poco con el uso que hacen los autores de conceptos físicos para intentar explicar cómo funcionan las cosas, aun en situaciones un poco delirantes.

Los autores, que cuando no dedican su tiempo a pensar en la física de los superhéroes trabajan en el estudio de la dinámica de fluidos biológicos, se concentran en este paper especialmente en temas de microfluídica, y en cómo los dispositivos actuales permitirían que Ant-Man y The Wasp respiren cuando se reducen al tamaño de un insecto. Uno de los principales desafíos que deben resolver estos superhéroes tiene que ver con el volumen de aire que pueden tomar sus pulmone: al reducirse en tamaño la cantidad de aire que pueden tomar en cada bocanada también se reduce, y se vuelve comparable a la que respiran los escaladores cuando se encuentran por encima de los ocho mil metros de altura (aunque en este último caso no se debe a un cambio de tamaño, sino al cambio en la densidad del aire con la altura). Pero como en el caso de los escaladores del Monte Everest, sin aclimatación o ayuda respiratoria, la falta de oxígeno puede generar complicaciones que pueden culminar en la muerte, o aún peor, pueden hacer peligrar la aparición de nuevas películas sobre Ant-Man y The Wasp.

Con un poco de ingenuidad y algo de publicidad (al fin y al cabo, el paper es también una forma de promocionar algunos resultados previos del mismo grupo sobre la microfluídica de la respiración en insectos), los autores discuten en detalle qué dispositivos microfluídicos sería necesario usar para asistir a la respiración de los superhéroes, y qué tipo de válvulas, compresores, bombas y tuberías se deberían utilizar. Y no contentos con esto, también discuten algunos aspectos sobre los cambios en el metabolismo de los superhéroes asociados al cambio de tamaño, y cómo estos cambios impactarían en la dinámica de fluidos en sus cuerpos. Con un largo de 16 páginas, el paper se lee rápidamente, y por encima de todo, entretiene. ¡Felices vacaciones!

Pablo Mininni es profesor en el Departamento de Física en Exactas-UBA e Investigador del CONICET.

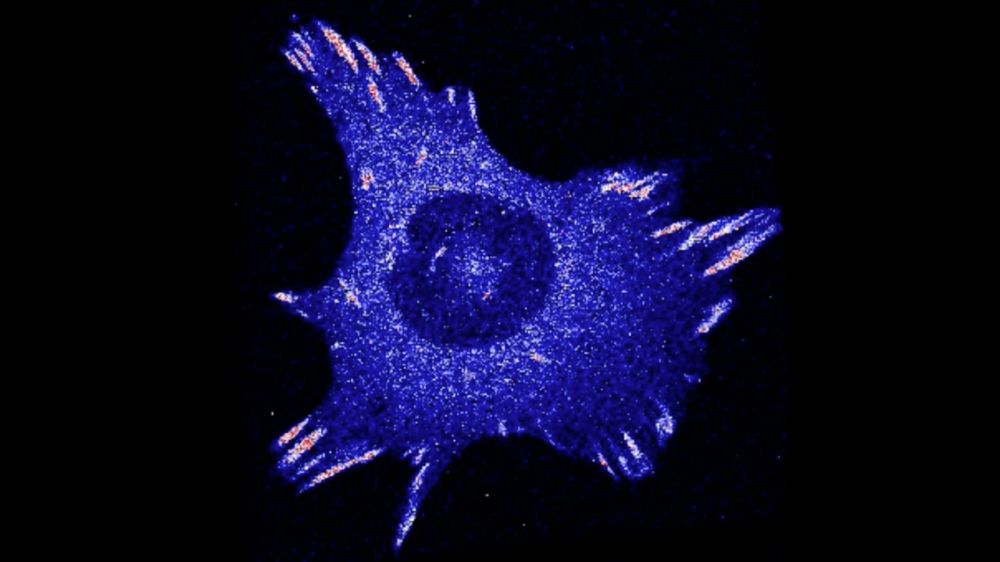

El grupo de Biofísica liderado por Lía Pietrasanta acaba de publicar los resultados de su investigación en Scientific Reports. Los investigadores estudian las respuestas de células mamarias ante un estímulo mecánico de estiramiento, simulando el proceso fisiológico natural. Lo novedoso es que han trabajado con células vivas, observando sus dinámicas en tiempo real a través del microscopio.

“La mayoría de las células en órganos y tejidos están sujetas constantemente a diversos estímulos externos. Nos interesa, en términos globales, el complejo proceso de mecanotransducción que realizan las células, es decir, cómo detectan las fuerzas mecánicas, las integran y convierten en señales bioquímicas. Estudiamos particularmente las células epiteliales de glándula mamaria porque resultan un sistema modelo interesante por los cambios producidos en sus adhesiones focales ante un estímulo mecánico externo”, explica la investigadora del Instituto de Física de Buenos Aires de UBA-CONICET, Lía Pietrasanta.

Las adhesiones focales son puntos de contacto que permiten a la célula agarrarse al sustrato. Son ensamblados hechos de aglomerados de proteínas -cerca de trescientas- que posibilitan el desplazamiento a modo de gateo sobre la matriz extracelular. “Nos interesan algunos aspectos particulares de estas proteínas, conocer cómo se mueven o el grado de estiramiento a nivel molecular de un tipo particular como la vinculina; cómo cambian de manera muy rápida ante el estímulo y también qué sucede con cada proteína a través mediciones locales”, dice Catalina von Bilderling y agrega: “En particular, para la vinculina evaluamos el estado de tensión molecular que posee cuando la célula es sometida al estrés mecánico por estiramiento. De igual manera, para la proteína zixina estudiamos la asociación y disociación a la adhesión focal con la técnica FRAP”.

La investigación se llevó a cabo con células de ratón que, típicamente, reciben estímulos de fuerzas con los cambios fisiológicos: “Cultivamos las células sobre sustratos de PDMS, una especie del film elástico transparente que permite ser estirado. Así, observamos las dinámicas que ocurren en vivo, marcamos ciertas proteínas y realizamos un seguimiento en función del tiempo”, describe otra de las autoras, Lorena Sigaut. “La investigación fue realizada íntegramente en el laboratorio: desde el cultivo de una línea celular, todo el proceso necesario para que crezca, se reproduzca y se mantenga el cultivo durante meses, hasta la identificación de las proteínas a estudiar y su seguimiento en el microscopio. Luego la información es analizada a través de modelos”, concluye.

Scientific Reports 8, 9788 (2018) |

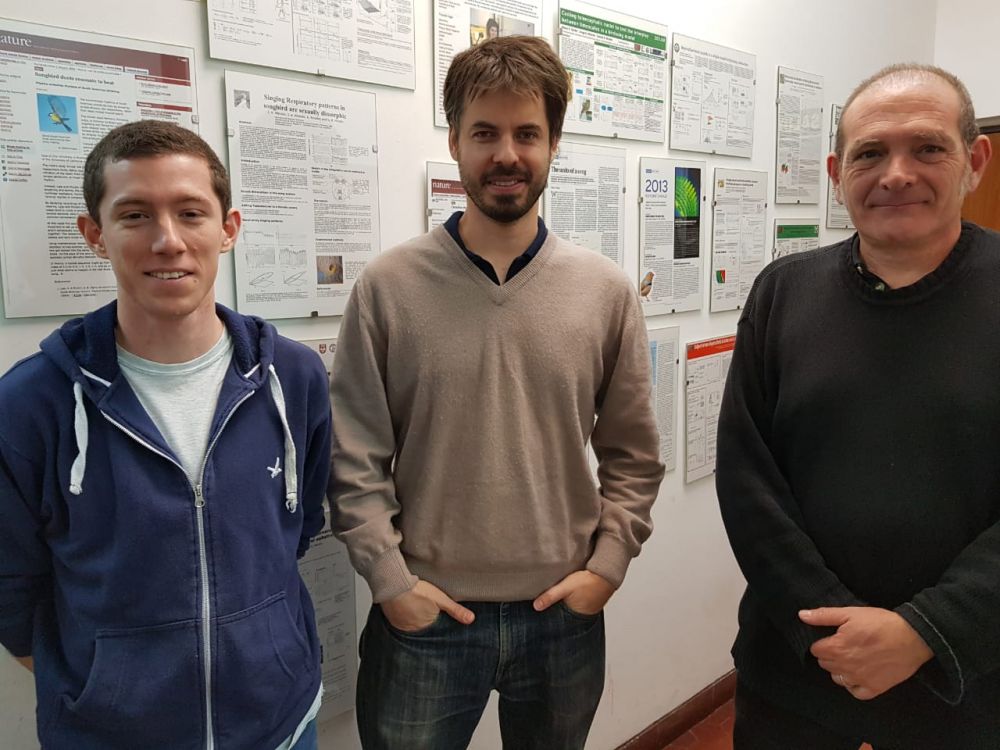

El estudio de las aves permite entender los principios de control vocal, es decir, cómo es que los animales hacen para producir esos complejos comportamientos que son las vocalizaciones. Hace muchos años que el laboratorio de Sistemas Dinámicos del Departamento de Física liderado por Gabriel Mindlin estudia a la aves Oscinas como modelo de fonación. Alan Bush, becario postdoctoral del laboratorio y primer autor de un trabajo recientemente publicado en la revista PNAS, cuenta que lo interesante del modelo animal son las características que comparte con los humanos: “Ambos tienen vocalizaciones complejas, aunque los pájaros que estudiamos en este trabajo no tienen diversidad en el canto, su música es estereotipada. Sin embargo, estas aves, al igual que nosotros, aprenden de un tutor al que deben escuchar mientras crecen y en base a lo oído desarrollan el canto típico de la especie”.

La publicación da cuenta de importantes conclusiones a las que el grupo, perteneciente al Instituto de Física de Buenos Aires de UBA-CONICET, llegó luego de comparar las respuestas de los pájaros ante dos estímulos diferentes: un audio de su propio canto y, el canto sintetizado por un modelo biomecánico del aparato fonador. “Ya en el año 2013 el laboratorio había logrado síntesis lo suficientemente buenas como para que el animal las crea como propias, ya que responde de manera muy similar a como lo hace con su propio canto”, aclara Bush.

El investigador explica que, por ejemplo, ante el canto de otro pájaro el ave no responde; o, si se realizan pequeñas perturbaciones en la vocalización en cuanto a la frecuencia tampoco emite réplica. La respuesta de las aves es tan específica que resulta un desafío conocer cuándo se produce y si lo hace con variaciones: “podemos controlar cómo se sintetiza un canto simulado y también variar los parámetros. En este caso, lo que hicimos fue degradar el canto sistemáticamente, lo empeoramos. Observamos que cuando se evoca una respuesta es idéntica a la producida ante el canto original, y que a mayor degradación disminuye la probabilidad de obtener esa misma réplica”, explica Bush y agrega que la respuesta es “a todo o nada”: o bien se ve el gesto motor de manera completa o no se advierte, en absoluto. “Lo que no observamos y bien podría resultar una hipótesis razonable, es la presencia de gestos degradados”.

El laboratorio desarrolla esta línea de investigación hace muchos años, en un primer momento, todo el sistema biomecánico involucrado en la producción de las vocalizaciones se modeló desde la física no lineal y, de a poco, el estudio viró hacia los circuitos neuronales que controlan la biomecánica de la periferia. “Lo que pudimos observar es que la respuesta evocada descrita a nivel del cerebro también ocurre en los músculos de la siringe. Es decir, que esta activación del sistema por un estímulo auditivo viaja hasta la periferia. Durante la noche el ave no canta porque no está acompañada de los gestos respiratorios que genera la presión necesaria para la fonación”. El investigador concluye que en este momento, se abre una ventana interesante hacia el estudio del sistema, porque “la información a nivel de activación del aparato fonador nos da una medida global de la activación del sistema que resulta complementaria a la de las activaciones neuronales. Podemos mirar la activación del sistema como un todo, desde otro lugar”.

Los autores de la publicación son Gabriel Mindlin, profesor del Departamento de Física e investigador superior del Conicet en IFIBA de Exactas, UBA; Alan Bush, becario postdoctoral de Conicet en IFIBA de Exactas, UBA; Juan F. Döppler,becario doctoral de Conicet en IFIBA de Exactas, UBA; y Franz Goller, investigador de la Universidad de Utah.

Syringeal EMGs and synthetic stimuli reveal a switch-like activation of the songbird’s vocal motor program. PNAS August 1, 2018. 201801251

www.pnas.org/lookup/suppl/doi:10.1073/pnas.1801251115/-/DCSupplemental.

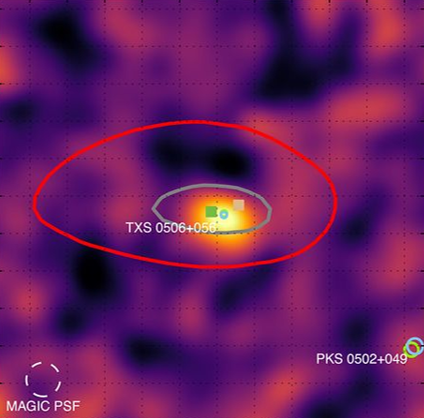

*Por Gastón Giribet

El 12 de julio pasado se anunció oficialmente un descubrimiento deslumbrante que, de ser confirmado, vendría a revolucionar la manera en la que observamos el universo. El descubrimiento tuvo lugar unos meses antes, el 22 de septiembre de 2017. Ese día, los detectores del observatorio Ice-Cube, en la Antártida, detectaron un neutrino que, según indicaran observaciones astronómicas de los días que siguieron, parece haber provenido de un astro brillante de la constelación de Orión, el blázar TXS 0506+056. Se trataría, así, de la primera identificación del origen de los rayos cósmicos que llegan a la Tierra y del inicio de un nuevo tipo de astronomía.

Rayos cósmicos provenientes de la constelación de Orión

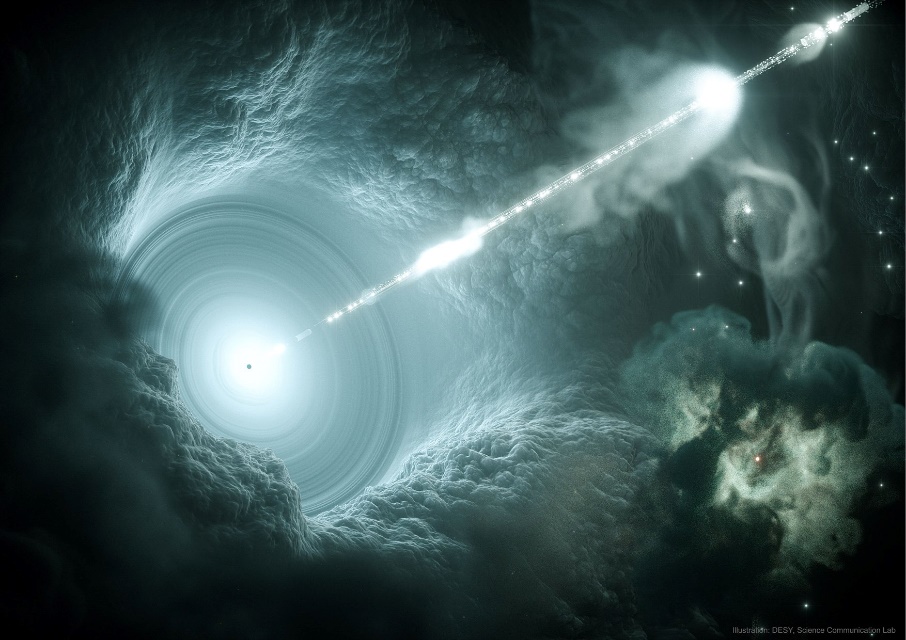

Un blázar es un fenómeno astrofísico de origen extragaláctico que está asociado a un tipo muy especial de galaxia con un núcleo activo. Muchas galaxias, si no todas ellas, tienen en su centro un agujero negro de enorme masa que es responsable de gran actividad. Violentos procesos astrofísicos ocurren en las inmediaciones de ese astro central, que recibe el nombre de agujero negro supermasivo debido a que su masa llega a ser varios órdenes de magnitud superior a la de las estrellas. La masa de un agujero negro supermasivo resulta proporcional a la de la galaxia que lo hospeda, un fenómeno para el que aún no existe explicación satisfactoria. En el caso de nuestra Vía Láctea, por ejemplo, el agujero negro que se halla en su centro es Sgr A*, con una masa de alrededor de 4 millones de veces la de nuestro Sol. En los casos de galaxias mayores, éstas llegan a albergar agujeros negros mucho más masivos, que alcanzan varios miles de millones de masas solares y que son fuente de gran actividad en el núcleo galáctico.

Los agujeros negros supermasivos generan un intenso campo gravitatorio que atrae la materia que se encuentra en sus inmediaciones. Así, estos astros terminan vistiéndose con un disco de acreción de materia ionizada, polvo, gas e incluso estrellas que son atraídas y eventualmente arrastradas a su interior. Toda esta materia, al encontrarse en agitación y fricción constante, arremolinada en una región reducida de unas fracciones de pársec cerca del agujero negro, alcanza temperaturas extremas. Esto lleva a la materia moribunda a emitir radiación de muy alta energía y propulsar partículas hacia el medio intergaláctico en forma de un jet colimado que se eleva en la dirección perpendicular al gran vórtice.

Lo que diferencia a un blázar de otra galaxia con núcleo activo no es sólo la existencia de jets ultraenergéticos sino también el hecho de que, por el azar de la distribución cósmica de los astros, uno de estos jets termina apuntando en la dirección de nuestro planeta. En resumen, los blázares son galaxias lejanas cuyos agujeros negros centrales emiten dos jets de partículas que se disparan en direcciones perpendiculares al torbellino de materia que ellos van ingiriendo, y uno de esos jets, providencial, nos ilumina a nosotros. Desde la Tierra, recibimos la luz y las partículas del chorro de energía, lo que aparece en nuestro mapa del cielo como una fuente de brillo inusual, una potente luz que nos habla de un violento ocurrir, allá, a lo lejos.

Representación artística de un blázar.

Los jets se componen de materia ionizada, partículas fundamentales y radiación electromagnética de diferentes frecuencias; en particular, rayos gamma. Su intensidad no es constante en el tiempo, ya que ésta depende de la cantidad de materia que el agujero negro supermasivo que les da origen esté consumiendo. Así, los blázares aparecen como objetos estelares de emisión variable, y experimentan períodos de mayor actividad que pueden durar algunos días. Sus fulguraciones pueden aumentar por lapsos breves y luego refluir a sus niveles medios.

El blázar TXS 0506+056, del que hablamos aquí, está ubicado a unos 3.700 millones de años luz de nosotros, en la dirección de lo que una arcaica manera de mapear el cosmos nos convence de llamar la constelación de Orión. La emisión de partículas, producto de una etapa de gran actividad de este blázar de Orión, es lo que se ha detectado recientemente en el observatorio Ice-Cube de la Antártida.

Centinela del hielo

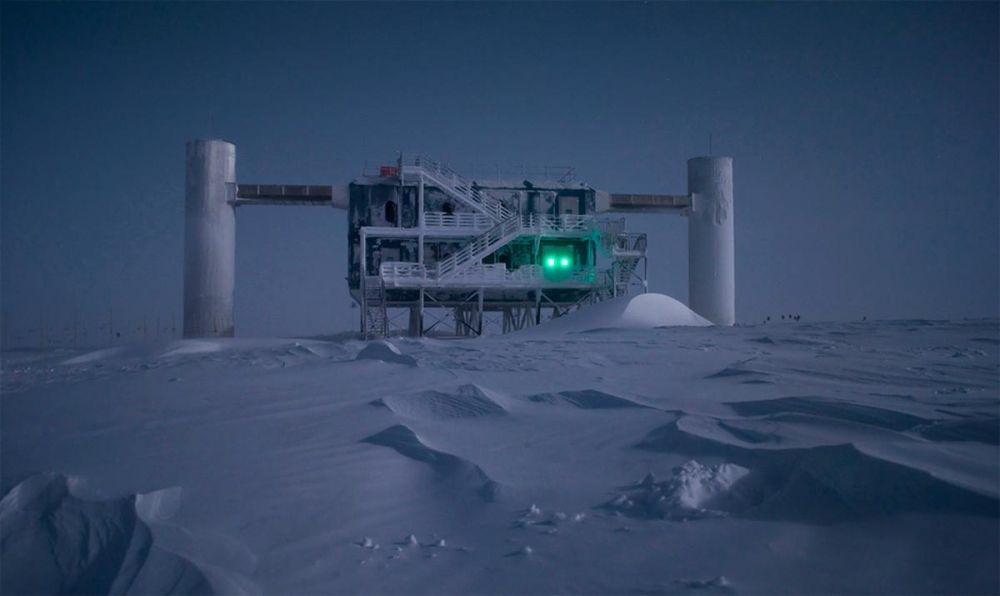

Ice-Cube es un observatorio de partículas emplazado en la Estación Científica Amundsen-Scott, en el continente blanco, muy cerca del polo sur. Fue construido con el propósito de detectar neutrinos, esas ligeras y escurridizas partículas que son renuentes a interactuar con la materia y que, por ende, son difíciles de atrapar.

Detectar neutrinos requiere, en efecto, de gran ingenio y de una sofisticada infraestructura, como la de Ice-Cube. El observatorio contiene 5.000 detectores enterrados en el suelo antártico, alojados en pequeñas cavidades talladas en el hielo, a pocos kilómetros de profundidad, dispersos en un volumen de un kilómetro cúbico de límpida agua congelada. Esos detectores, llamados módulos, se componen de cámaras muy sensibles provistas de un fotomultiplicador y una pequeña computadora. Enterrados allí, en el hielo austral, los módulos monitorean continuamente el gran volumen de hielo esperando rastros del paso de una partícula extraña que dispare la señal.

El observatorio Ice-Cube en el polo sur.

Los neutrinos, como decíamos, son reacios a interactuar con la materia, e incluso con ellos mismos. Sólo lo hacen por medio de la llamada fuerza nuclear débil –y de la fuerza gravitatoria, que es aún más débil–, lo que los hace indiferentes tanto a la mayoría de las reacciones nucleares cuanto a las interacciones electromagnéticas de cualquier frecuencia; es decir, los neutrinos son, literalmente, partículas elementales invisibles. Por consiguiente, aunque constantemente llegan la Tierra provenientes de todas las direcciones y de manera copiosa, su baja propensión a interaccionar con la materia lleva a los neutrinos a atravesar nuestro planeta sin siquiera notarlo. Sólo una pequeñísima, por lo general indetectable, cantidad de neutrinos termina por interactuar con algún átomo de nuestro planeta. Esto hace casi improbable que un neutrino, en su andar el universo, venga a impactar justo con un átomo del escaso kilómetro cúbico de hielo custodiado por los detectores de Ice-Cube.

Es precisamente gracias a esta baja probabilidad de detectar neutrinos –probabilidad que no es nula sino pequeña– que sabemos de ellos. Para entender esto debemos invertir el razonamiento de arriba: Si Ice-Cube viniera a detectar el paso de algunos neutrinos, la improbabilidad de tal suceso significaría que una inusual cantidad de ellos debió haber llegado a la Tierra en el momento de la detección. Sólo así se entendería que algunos ejemplares de tan escurridiza especie quedaran atrapados en nuestras redes. “El cardumen hubo de ser grande”, concluiríamos.

Eso ocurrió el 22 de septiembre pasado, y en algunas otras pocas ocasiones desde que Ice-Cube comenzó a funcionar, allá por finales de 2010. La primera detección apreciable de neutrinos en Ice-Cube tuvo lugar en 2013, y desde entonces algunas decenas de neutrinos en el rango de energías del tera-electronvoltio fueron observados en el hielo antártico. En particular, los detectores de Ice-Cube encendieron sus alarmas el 22 de septiembre pasado, y esta vez se trató de un evento muy especial.

Los eventos de septiembre

Lo que Ice-Cube detectó fue, en realidad, la radiación electromagnética producida por una serie de procesos que la colisión de un neutrino con un átomo desencadena. Al tratarse de detectores ópticos, los módulos de Ice-Cube no detectan el neutrino directamente –los neutrinos no interaccionan con la luz–. Lo que en realidad ocurre es que, al colisionar con las partículas que componen los átomos en el hielo, el neutrino genera una partícula llamada muón, que es similar al electrón pero unas dos mil veces más pesada. Este muón, al ser una partícula cargada eléctricamente, sí interacciona con la luz. Éste puede desplazarse por unos pocos metros dentro del hielo acarreando una porción del impulso que el neutrino original le supo propinar y finalmente emitir luz. Es la luz producida por el muón lo que los detectores ópticos colectan. Se trata, así, de una detección indirecta –como lo es todo ver– pero que aun así permite reconstruir la trayectoria y cantidades cinemáticas del neutrino que desencadenó la serie de procesos.

En el evento detectado el 22 de septiembre de 2017 lo que en realidad se vio fue eso, un muón; pero un muón muy sospechoso: La partícula apareció en las cámaras de Ice-Cube trayendo una inclinación inesperada, como si hubiera venido del centro de la tierra y no desde el espacio. Los muones se generan también en la alta atmósfera y, aunque muchos mueren en el trayecto, una gran cantidad de ellos llega a la superficie terrestre sin mayor dificultad. Por ello, la detección de muones provenientes del cielo no sería algo extraño. Lo que sí es difícil de explicar es que un muón con la energía del observado esa nochecita de la primavera austral provenga, no del cielo, sino de la misma masa terrestre. Los muones, a diferencia de los neutrinos, no pueden atravesar la masa rocosa del planeta sin desaparecer en el intento. Esto es síntoma inequívoco de que ese muón detectado acababa de ser creado por algo más, alguna partícula predecesora; ese muón no era sino el postrer aliento de un neutrino cansino que hasta ahí llegó, un neutrino proveniente de una fuente lejana.

A la pregunta de cuáles son las chances de detectar un neutrino de esa energía en el kilómetro cúbico de hielo monitoreado por el observatorio antártico le cabe una enfática respuesta: Bajísimas. De esto concluimos que, si vimos uno, pues es que debió haber una cantidad inusual de ellos; una copiosa lluvia de neutrinos debió acaecer ese día de septiembre.

El hielo y el cielo

Los detectores de Ice-Cube dispararon una alarma a los pocos segundos de haber detectado el paso de la partícula. Menos de un minuto después del hallazgo el evento ya tenía su nombre (Ice-Cube170922A) y se alertaba a distintos observatorios astronómicos en diferentes puntos del planeta, incluyendo los que operan telescopios a bordo de satélites. La idea era que, conociendo la dirección aproximada de la cual la lluvia de neutrinos parecía provenir –lluvia de la que sólo una gota había sido retenida por los detectores–, los telescopios enfocarían sus esfuerzos en esa región del firmamento para buscar allí evidencia de algún evento astrofísico que pudiera ser identificado como la fuente del inusual chorro de partículas.

Imagen del blázar TXS0506+056

Cuando los fenómenos astrofísicos muy energéticos tienen lugar, por lo general las emisiones de materia y energía se producen en varias formas, en diferentes partes del espectro, en distintos tipos de radiación. Así, se esperaba que la emisión de neutrinos viniera acompañada de contrapartes electromagnéticas, en rayos X o en rayos gamma. Lo que hace a esta historia interesante es que tales emisiones compañeras fueron, en efecto, observadas.

Mediciones inusuales en el espectro de rayos X fueron las primeras en ser detectadas. Tal como se anunciaba un día después, el 23 de septiembre, casi una decena de fuentes activas en rayos X fueron identificadas en la región del cosmos de la cual los neutrinos parecían provenir; entre ellas, el blázar TXS 0506+056, hoy sindicado como el responsable. La confirmación vino unos días después, sobre fines de septiembre, cuando el telescopio de gran área LAT, a bordo del satélite Fermi de la NASA y con la misión de vigilar celosamente miles de blázares, anunciaba una inusual actividad en TXS 0506+056, en la constelación de Orión, de donde los neutrinos parecían provenir. Observaciones en radio y otras frecuencias también fueron realizadas.

La correlación entre la actividad inusual de rayos gamma en TXS 0506+056 y el arribo de una gran cantidad de neutrinos a la Tierra excitó a la comunidad. La coincidencia en la dirección angular y en el tiempo de ambos fenómenos deja pocas dudas. Como se suele decir en estos casos, aquello era ver la pistola humeando luego de haber oído el disparo.

A raíz de este descubrimiento, la colaboración científica Ice-Cube emprendió la tarea de revisar detecciones previas de neutrinos, acaecidas en los años anteriores, entre 2012 y 2017. Encontraron en ese registro más evidencia del origen de las lluvias observadas.

Esta es la primera vez que se identifica con tanta claridad la posible fuente de neutrinos de ese nivel de energía. Los neutrinos, aunque tienen una pequeñísima masa y, por lo tanto, no pueden viajar a la velocidad de la luz, sí lo hacen a una velocidad muy cercana a ésa. Es por ello que, aunque provenientes de miles de millones de años luz, la señal de rayos gamma del blázar y los neutrinos llegan a la tierra casi simultáneamente.

Este descubrimiento es de enorme importancia, dado que se trata de la primera vez que se identifica la fuente de rayos cósmicos de tal energía. Si bien es cierto que conocemos de la existencia de rayos cósmicos desde hace más de un siglo, que sabemos del origen extrasolar de la mayoría de ellos, que sospechamos del origen extragaláctico de muchos de ellos, y que tenemos teorías al respecto en las que bien confiamos, también es cierto que hasta el momento las únicas fuentes identificadas de los neutrinos que arriban a la Tierra eran dos: el Sol y la explosión de supernova observada en 1987 (denominada SN1987A). La detección de neutrinos en Ice-Cube el 22 de septiembre de 2017 y su correlato con la actividad del blázar TXS 0506+056 es la primera identificación del origen de un flujo de neutrinos de altas energías.

Sumando fuerzas para mapear el cosmos

Esto parece hitar el comienzo de una nueva etapa de la astronomía. Hasta 2015, la astronomía se restringía a la observación de la luz proveniente de los astros y la consecuente tarea de inferir qué procesos físicos podrían dar origen a la emisión observada. Y si bien la vastedad del espectro electromagnético nos permitió estudiar diferentes rangos de energías y diferentes tipos de fenómeno, el principio físico atrás de toda observación astronómica era el mismo: Tanto la astronomía convencional, como la radioastronomía, o la astronomía en el infrarrojo, o en el espectro de rayos X o de rayos gamma, son todas subdisciplinas basadas en lo mismo, la detección de la luz del proceso distante. La historia comenzó a cambiar en 2015, a partir de la detección de las ondas gravitacionales en los observatorios LIGO y Virgo. Se abrió entonces la ventana a un nuevo tipo de astronomía, que ya no percibe al cosmos simplemente por la luz que sus astros emiten, sino que lo hace escuchando también las perturbaciones del campo gravitatorio que esos astros, muchos invisibles, producen en su andar y encontrarse. Ahora, a la luz de esta observación de los neutrinos producidos por el blázar de Orión, una tercera manera de sentir el cosmos parece sumarse a las anteriores: Ya no son la electromagnética y la gravitatoria las únicas fuerzas con las que sentimos el universo, sino que ahora también la fuerza nuclear débil contribuye a la empresa. Es esta última fuerza la que genera los neutrinos en galaxias distantes que, luego de un trayecto extenuante de miles de millones de años luz, quedan atrapados allí, en los hielos del sur.

Referencias

[1] Neutrino emission from the direction of the blazar TXS 0506+056 prior to the IceCube-170922A alert, by the IceCube Collaboration, in Sciences, July 12th, 2018.

http://science.sciencemag.org/content/early/2018/07/11/science.aat2890.full

[2] Multimessenger observations of a flaring blazar coincident with high-energy neutrino IceCube-170922A, by the IceCube Collaboration, in Sciences, July 12th, 2018.

http://science.sciencemag.org/content/early/2018/07/11/science.aat1378.full

[3] Single subatomic particle illuminates mysterious origins of cosmic rays, in Nature, July 13th, 2018. https://www.nature.com/articles/d41586-018-05703-y

(*) Gastón Giribet, Profesor del Departamento de Física, Exactas, UBA. Investigador Principal en IFIBA de UBA-CONICET. Investigador del Centro de Cosmología y Física de Partículas de New York University.

GENis es un software diseñado para contribuir al esclarecimiento de delitos a través de coincidencias entre el perfil genético de una muestra de ADN con aquellos cargados en el sistema. La herramienta desarrollada íntegramente en Argentina busca efectivizar procesos en criminalística, como así también ayudar a resolver casos de desapariciones de personas o en la identificación de individuos víctimas de desastres masivos.

Ariel Chernomoretz es coordinador del equipo científico de GENis, y explica que uno de los objetivos del soft es brindar una herramienta a la justicia para sacar el máximo provecho de muestras genéticas encontradas en escenas del crimen, facilitando la posibilidad de incorporar en el análisis el uso de bases de datos locales, regionales y nacionales, y homologando al mismo tiempo un protocolo de trabajo. “Este es un proyecto que comenzó en 2014, ya está operativo en cuatro provincias y recientemente obtuvo las firmas necesarias para funcionar en otras catorce”, explica el profesor del DF, investigador en IFIBA de UBA-Conicet y director de un laboratorio en el Instituto Leloir.

“Es un proyecto súper interesante porque dialogamos con desarrolladores de soft, abogados y fiscales, en torno a temas de mucha actualidad, con profundas implicancias sociales, y cada uno hace su parte. Nosotros, desde la pata científica, si puede decirse así, buscamos tener una herramienta lo más confiable posible, acorde a estándares internacionales, con el objetivos de interconectar laboratorios y ser lo más eficiente posible”, asegura el físico.

La huella digital genética

El genoma de cada individuo tiene diferencias suficientes para identificar casi unívocamente una persona y diferenciarla de otra. La técnica forense consiste en utilizar unos marcadores que se encuentran en la parte no codificante del genoma, que son pequeños fragmentos de ADN con “poquitas letras”. De acuerdo a cuántas veces se repite esa “frase” en el perfil da como resultado una huella digital única, una especie de código de barras para los distintos marcadores que permite identificar individuos.

“La idea es tener un sistema con el que cotejar si hay match entre la evidencia de ADN levantada en un escena de crimen con alguna persona ya registrada en la base de datos; identificar reincidencia; encontrar la conexión de delitos cometidos en distintos territorios para unificar causas, etc.”, asegura Chernomoretz y agrega que otra posibilidad que permite el soft es el cotejo de datos en la búsqueda de personas desaparecidas, donde se vincula a la persona que ingresó como NN en una base de datos con la familia que lo está buscando”.

Según el investigador, el proceso de cotejo de correspondencia debe hacerse de manera eficiente, porque las bases de datos poseen volúmenes considerables. “Por ejemplo, si dentro de una determinada población tomamos a una persona cualquiera, ¿qué tan probable es que el matching haya ocurrido por azar? Para responder a esa pregunta utilizamos el p-value, una medida de la significancia estadística del match. Con la tecnología que se usa en la mayoría de los laboratorios se logran valores muy bajos de p-value, lo que da una confianza muy grande en los matchs, por lo tanto, se rechaza la casualidad y comienza a pensarse en la causalidad”.

Luego de cotejar los datos a través del software, los usuarios reportan los resultados al juez de la causa en cuestión. “Es importante decir que no puede idealizarse esta herramienta, los resultados deben ser ponderados en el contexto de otras evidencias y del propio trabajo del juez”, aclara.

Desafíos técnicos y políticos

“Hay situaciones complejas, como cuando en un escena del crimen se encuentran muestras de más de un aportante, eso implica deconstruir la señal para encontrar a los contribuyentes más probables. Lo que reportamos es un cociente de verosimilitudes, es decir, cuánto más probable es haber encontrado la muestra en cuestión dada la hipótesis del fiscal, por ejemplo, en contraposición a la hipótesis propuesta por el defensor. Entre dos posibilidades, el cociente nos dice qué escenario tiene mayor probabilidad”. El mismo tipo de estadística se utiliza para la búsqueda de personas desaparecidas, “tenemos un pedigrí formado por padres, hijos, sobrinos, nietos, y, en ese caso, medimos la posibilidad de que una persona pertenezca o no la genealogía familiar. La verosimilitud de un pedigrí es algo costoso computacionalmente, en ese caso utilizamos una técnica basada en lo que se conoce como redes bayesianas”.

Chernomoretz asegura que la puesta en uso de la herramienta suma complejidad porque involucra coordinar legislaciones de distintas provincias: “a veces, ni siquiera existen o si las hay, difieren mucho en los alcances que cada una plantea para las bases de datos”. Sin embargo, el soft tiene claras ventajas para el país, ya que “crea una comunidad de usuarios y desarrolladores locales, donde la interacción es muy fructífera, y donde aparecen nuevos desafíos todo el tiempo. Otra virtud es que es un soft open source, por lo que todos los algoritmos están publicados o por publicarse, y fue construído con software libre”.

La herramienta informática es financiada por la Fundación Sadosky a partir de un requerimiento de la Sociedad Argentina de Genética Forense y cuenta con el apoyo del Ministerio de Ciencia, Tecnología e Innovación productiva de la Nación. Sin embargo, compite en su implementación con el software desarrollado por el FBI, CoDIS (Combined DNA IndexSystem) que intenta imponer el Ministerio de Seguridad de la Nación. En este sentido el científico cuenta: “el soft importado se licencia de manera gratuita mediante la firma de acuerdos de uso -una licencia que se puede revocar- y es muy restrictivo por lo que no podemos conocer características de uso y difusión de su tecnología. Como es un sistema de caja cerrada, no se conoce bien qué hace. La licencia es gratis, aunque sabemos que nada lo es, tiene algunos costos. De todos modos, lo problemático es que se puede revocar la licencia de un momento a otro y si toda la justicia se monta sobre este sistema quedas desvalido. En cambio, GENis promueve la formación de recursos humanos en el área y para nosotros es una oportunidad de crecimiento muy grande a nivel local y también global, porque no hay muchos softs de este tipo”.

“Como encargado de la parte científica del proyecto la preocupación es cumplir con todos los requerimientos, validar el soft todas las veces que sea necesario a través de organismos competentes como el Banco Nacional de Datos Genéticos, el grupo de desarrollo de soft de la UBA, que se ocupa de validar todas las especificaciones que sean las correctas, es decir, que todo lo que se dice que el programa hace, se haga, y también de la Sociedad Argentina de Bioinformática y Biología Computacional”, concluye el físico.

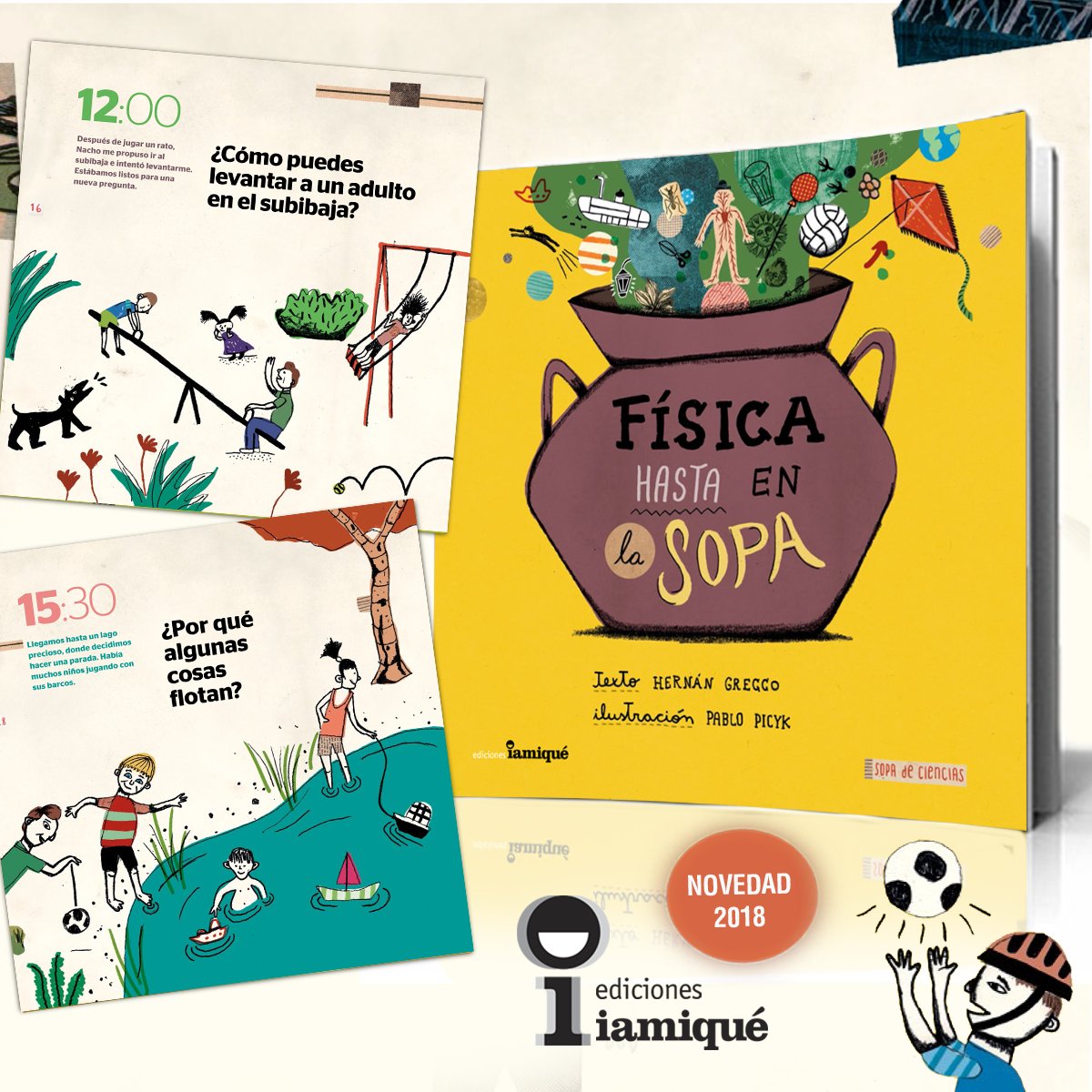

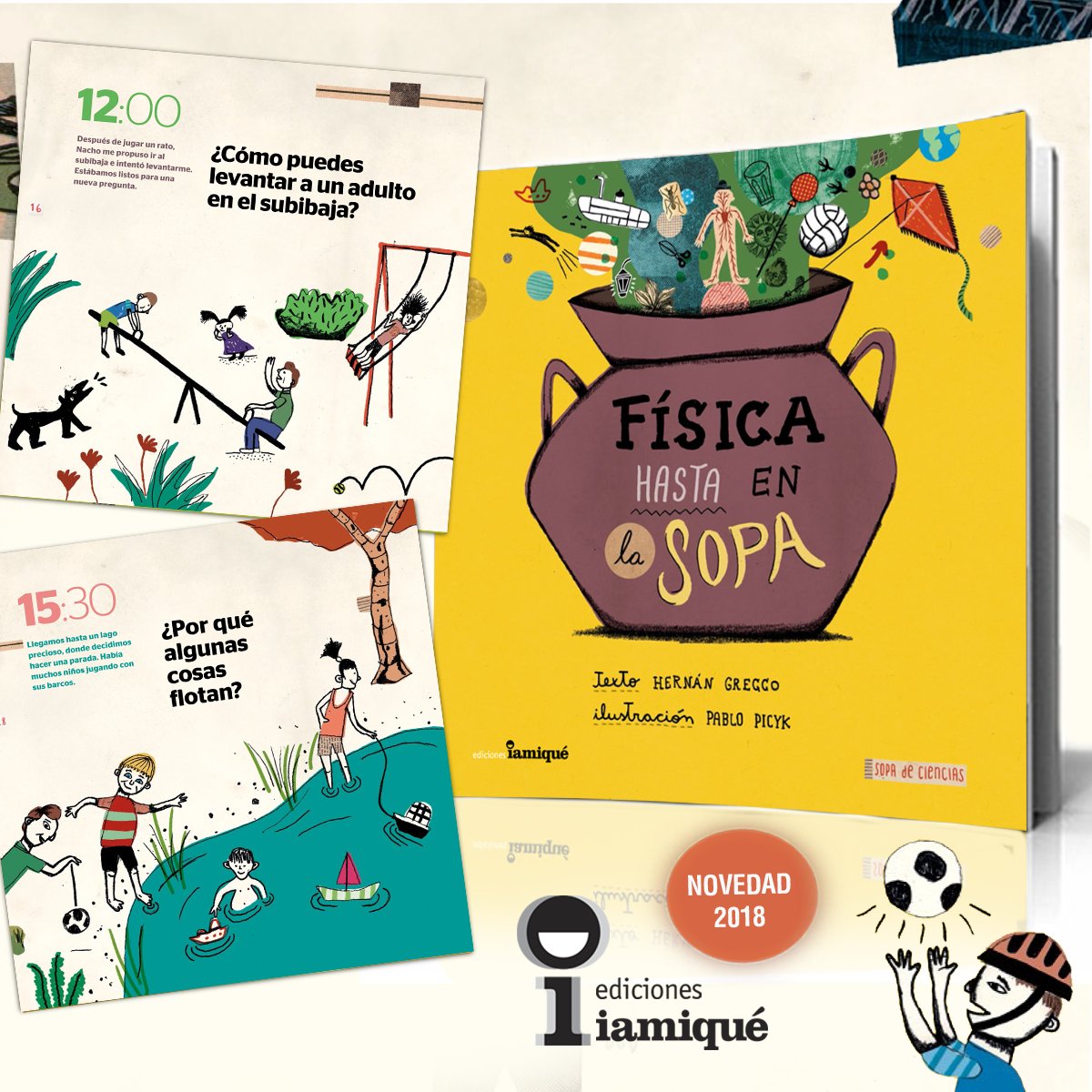

Física hasta en la sopa se llama el primer libro de Hernán Grecco, profesor del Departamento de Física, que publicó Ediciones Iamiqué hace pocos días. ¿Por qué rebota la pelota?, ¿qué es un cortocircuito?, ¿por qué el sol se ve rojo al atardecer?, o ¿cómo puedes levantar a un adulto en el subibaja? son preguntas que se hace cualquier chico… y los no tanto también.

“Componer este libro fue un proceso muy enriquecedor porque aunque escribo seguido textos técnicos y otros que no lo son tanto, ahora tenía que pensar en lectores de ocho años, respetar un espacio más limitado, y además, generar algo atractivo, entretenido, en un lenguaje llano y sin jerga”.

El libro, y toda la colección de ciencia para niños que propone Iamiqué, apuesta a otros lenguajes, desde dibujos -Ilustraciones de Pablo Picyk -que crean situaciones y contextualizan las preguntas, los colores, las tipografías hasta el uso de recursos como palabras claves crean un ambiente más atrapante, en la definición del físico.

“En la escritura fui probando, claro, le mostré los textos a mis hijos y también les leí partes, lo compartí con los amigos de los chicos, con mis sobrinos, con niños cuyos padres no son físicos; y en función de las reacciones afiné el texto: pude saber lo que quedaba claro y lo que no. Pero fue imprescindible la lectura crítica de Carla Baredes en todo lo que escribí”. Carla es física y junto a la bióloga Ileana Lotersztain fundaron la editorial, son egresadas de Exactas como muchos de los autores que publican.

“En la escritura fui probando, claro, le mostré los textos a mis hijos y también les leí partes, lo compartí con los amigos de los chicos, con mis sobrinos, con niños cuyos padres no son físicos; y en función de las reacciones afiné el texto: pude saber lo que quedaba claro y lo que no. Pero fue imprescindible la lectura crítica de Carla Baredes en todo lo que escribí”. Carla es física y junto a la bióloga Ileana Lotersztain fundaron la editorial, son egresadas de Exactas como muchos de los autores que publican.

Hernán no recuerda haber leído este tipo de colecciones cuando era chico, pero sí Cosmos de Carl Sagan y coleccionar láminas del sistema solar o de dinosaurios. “Me parece que ha habido una revalorización de la comunicación pública de la ciencia en el último tiempo, que se ha multiplicado la diversidad. Después de hacer una carrera como física, lo difícil es salirse de los tecnicismos, escapar de las palabras específicas de la disciplina, de las ecuaciones. El ejercicio más interesante es poder volver a las fuentes, este libro es eso para mí: ir a lo importante”.

El físico Gabriel Mindlin publicó su cuarto libro, esta vez inspirado en sus clases de Dinámica no lineal que han tomado cientos de estudiantes con fuerte vocación cuantitativa, tal como describe él mismo. El texto forma parte de la colección “Nuevos enfoques en ciencia y tecnología” de la Editorial UNQ, para abastecer la búsqueda de nuevos enfoques, entendidos como nuevos conocimientos en marcos disciplinares y socioeconómicos diferentes. Diego Golombek escribió estas palabras para la contratapa del libro:

Cambia, todo cambia… y la física y la matemática se unen para entender esos cambios, ya sean en el clima, el cerebro, el canto de las aves o cualquier variable de la naturaleza. A veces esos cambios son poco predecibles, dependen de variaciones minúsculas, crecen sin cesar o regresan sobre sí mismos como una especie de ritornello musical. En este mundo de nunca acabar se instala la dinámica no lineal, con su bagaje de herramientas necesarias para los físicos, sí, pero también para los químicos, ingenieros, climatólogos y, más recientemente, economistas perplejos o biólogos que quieren entender de qué se tratan las neuronas, el corazón o las poblaciones de los peces.

Y si hay un experto en el tema en la Argentina, sin duda es Gabriel Mindlin, profesor del Departamento de Física de la Facultad de Ciencias Exactas y Naturales de la UBA, investigador superior del Conicet y ciudadano científico del mundo. Este libro compila las “notas de campo” de su antológico curso de Dinámica lineal y abre un abanico de posibilidades para todo científico que quiera comprender su modelo de estudio en profundidad. Además de la base introductoria del tema y su profundización en técnicas avanzadas de dinámica no lineal, el texto incluye numerosos ejemplos, muchas veces extraídos de las investigaciones del propio autor, publicadas -y premiadas - en las mejores revistas del mundo.

Física hasta en la sopa se llama el primer libro de Hernán Grecco, profesor del Departamento de Física, que publicó Ediciones Iamiqué hace pocos días. ¿Por qué rebota la pelota?, ¿qué es un cortocircuito?, ¿por qué el sol se ve rojo al atardecer?, o ¿cómo puedes levantar a un adulto en el subibaja? son preguntas que se hace cualquier chico… y los no tanto también.

“Componer este libro fue un proceso muy enriquecedor porque aunque escribo seguido textos técnicos y otros que no lo son tanto, ahora tenía que pensar en lectores de ocho años, respetar un espacio más limitado, y además, generar algo atractivo, entretenido, en un lenguaje llano y sin jerga”.

El libro, y toda la colección de ciencia para niños que propone Iamiqué, apuesta a otros lenguajes, desde dibujos que crean situaciones y contextualizan las preguntas, los colores, las tipografías hasta el uso de recursos como palabras claves crean un ambiente más atrapante, en la definición del físico.

“En la escritura fui probando, claro, le mostré los textos a mis hijos y también les leí partes, lo compartí con los amigos de los chicos, con mis sobrinos, con niños cuyos padres no son físicos; y en función de las reacciones afiné el texto: pude saber lo que quedaba claro y lo que no. Pero fue imprescindible la lectura crítica de Carla Baredes en todo lo que escribí”. Carla es física y junto a la bióloga Ileana Lotersztain fundaron la editorial, son egresadas de Exactas como muchos de los autores que publican.

“En la escritura fui probando, claro, le mostré los textos a mis hijos y también les leí partes, lo compartí con los amigos de los chicos, con mis sobrinos, con niños cuyos padres no son físicos; y en función de las reacciones afiné el texto: pude saber lo que quedaba claro y lo que no. Pero fue imprescindible la lectura crítica de Carla Baredes en todo lo que escribí”. Carla es física y junto a la bióloga Ileana Lotersztain fundaron la editorial, son egresadas de Exactas como muchos de los autores que publican.

Hernán no recuerda haber leído este tipo de colecciones cuando era chico, pero sí Cosmos de Carl Sagan y coleccionar láminas del sistema solar o de dinosaurios. “Me parece que ha habido una revalorización de la comunicación pública de la ciencia en el último tiempo, que se ha multiplicado la diversidad. Después de hacer una carrera como física, lo difícil es salirse de los tecnicismos, escapar de las palabras específicas de la disciplina, de las ecuaciones. El ejercicio más interesante es poder volver a las fuentes, este libro es eso para mí: ir a lo importante”.

El físico Gabriel Mindlin publicó su cuarto libro, esta vez inspirado en sus clases de Dinámica no lineal que han tomado cientos de estudiantes con fuerte vocación cuantitativa, tal como describe él mismo. El texto forma parte de la colección “Nuevos enfoques en ciencia y tecnología” de la Editorial UNQ, para abastecer la búsqueda de nuevos enfoques, entendidos como nuevos conocimientos en marcos disciplinares y socioeconómicos diferentes. Diego Golombek escribió estas palabras para la contratapa del libro:

Cambia, todo cambia… y la física y la matemática se unen para entender esos cambios, ya sean en el clima, el cerebro, el canto de las aves o cualquier variable de la naturaleza. A veces esos cambios son poco predecibles, dependen de variaciones minúsculas, crecen sin cesar o regresan sobre sí mismos como una especie de ritornello musical. En este mundo de nunca acabar se instala la dinámica no lineal, con su bagaje de herramientas necesarias para los físicos, sí, pero también para los químicos, ingenieros, climatólogos y, más recientemente, economistas perplejos o biólogos que quieren entender de qué se tratan las neuronas, el corazón o las poblaciones de los peces.

Y si hay un experto en el tema en la Argentina, sin duda es Gabriel Mindlin, profesor del Departamento de Física de la Facultad de Ciencias Exactas y Naturales de la UBA, investigador superior del Conicet y ciudadano científico del mundo. Este libro compila las “notas de campo” de su antológico curso de Dinámica lineal y abre un abanico de posibilidades para todo científico que quiera comprender su modelo de estudio en profundidad. Además de la base introductoria del tema y su profundización en técnicas avanzadas de dinámica no lineal, el texto incluye numerosos ejemplos, muchas veces extraídos de las investigaciones del propio autor, publicadas -y premiadas - en las mejores revistas del mundo.

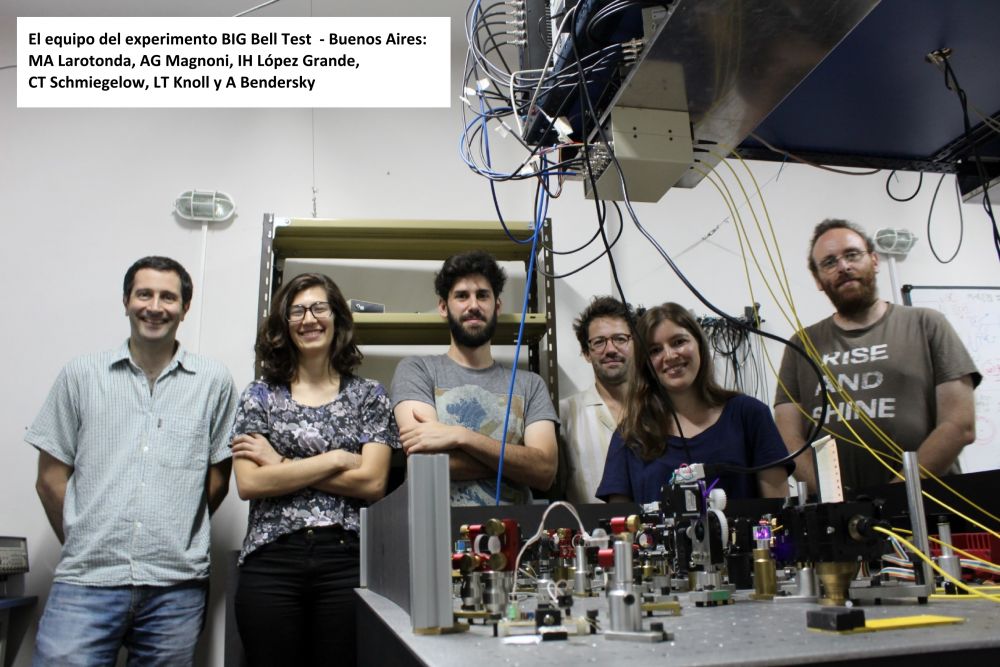

Experimentos simultáneos en cinco continentes desafían el principio de realismo local imaginado por Einstein. Los participantes contribuyeron al experimento generando más de 90 millones de bits, eligiendo en forma impredecible distintas mediciones para eludir la paradoja conocida como “la trampa (loophole) de libertad de elección”. Este estudio fue publicado en la revista Nature.

El 30 de Noviembre de 2016, más de 100.000 personas alrededor del mundo contribuyeron a un conjunto de experimentos de física, primeros en su género, conocido como The BIG Bell Test. Usando smartphones y otros dispositivos con conexión a internet, los participantes aportaron bits impredecibles, que fueron utilizados para determinar de qué manera iban a ser medidos átomos entrelazados, fotones y dispositivos superconductores en doce laboratorios distribuidos por todo el mundo. Los científicos utilizaron este aporte humano para cerrar un loophole, es decir una ambigüedad, que se presenta en forma ubicua en los experimentos del principio de realismo local de Einstein. Los resultados ya han sido analizados, y se reportan en la edición de esta semana de la revista Nature.

En un test de Bell (así llamado por el físico John Stewart Bell), pares de partículas entrelazadas como fotones se generan y se envían a distintas ubicaciones, en las que se mide alguna propiedad de estas partículas como el color de los fotones o su tiempo de llegada. Si los resultados de las mediciones tienden a coincidir, independientemente de qué propiedades elijamos medir, esto tiene implicaciones muy sorprendentes: o la medición sobre una partícula afecta en forma instantánea a la otra partícula (a pesar de estar alejadas entre sí), o – aún más extraño – estas propiedades nunca existieron: fueron creadas por la misma medición. Cualquiera de estas posibilidades contradice el realismo local, la cosmovisión de Einstein sobre un universo independiente de nuestras observaciones, en el cual ninguna influencia ni información puede viajar más rápido que la luz.

El BIG Bell Test les pidió a voluntarios humanos, conocidos como Bellsters, elegir las mediciones, para cerrar el llamado “loophole de libertad de elección” – la posibilidad de que las propias partículas influencien la elección de de la medición. Tal influencia, si existiera, invalidaría el test; sería como si se les permitiera a los estudiantes escribir las preguntas de sus propios exámenes. Este loophole no se puede cerrar eligiendo con un dado o un generador de números aleatorios, porque siempre existe la posibilidad de que estos elementos físicos estén coordinados con las partículas entrelazadas. Las elecciones humanas introducen el componente de libertad de elección, por el cual las personas pueden elegir independientemente de lo que fuera que las partículas pudieran estar haciendo.

Liderado por el ICFO-The Institute of Photonic Sciences, en Barcelona, el BIG Bell Test reclutó participantes alrededor del mundo para contribuir con secuencias de ceros y unos (bits) impredecibles, a través de un videojuego online. Los bits fueron enrutados a experimentos de vanguardia en Brisbane, Shanghai, Viena, Roma, Munich, Zurich, Niza, Barcelona, Buenos Aires, Concepción (Chile) y Boulder (EUA), donde fueron utilizados para ajustar los ángulos de rotación de polarizadores y otros elementos de laboratorio, que determinaron de qué manera se medirían las partículas entrelazadas.

Los participantes contribuyeron con más de 90 millones de bits, posibilitando un test severo para el realismo local, así como también otros experimentos sobre realismo en la mecánica cuántica. Los resultados obtenidos muestran una fuerte discrepancia con la visión de Einstein, cierran por primera vez el loophole de libertad de elección, y ensayan varios métodos nuevos para el estudio del entrelazamiento y el realismo local.

EL EXPERIMENTO de Entrelazamiento en Polarización de Buenos Aires (CITEDEF-UBA)

Cada uno de los doce laboratorios distribuidos por el mundo llevaron a cabo un experimento diferente, para probar el realismo local en distintos sistemas físicos y para probar otros conceptos relacionados con el realismo. El experimento realizado en el Laboratorio de Óptica Cuántica de CITEDEF (Buenos Aires) por investigadores de CITEDEF, CONICET y la UBA, estudió la violación de la desigualdad de CHSH-Bell (una medida de la discrepancia entre la realidad y las teorías de realismo local) utilizando fotones entrelazados en polarización, generados por conversión paramétrica descendente en un arreglo de cristales no lineales. El experimento completo utilizó 10.033 bits aleatorios, generados por Bellsters distribuidos alrededor del mundo y transmitidas por los servidores del BBT en Barcelona; estos bits definían distintas configuraciones para la medición de la polarización. El experimento resultó en una violación de la desigualdad de CHSH-Bell por siete desviaciones estándar. Esto significa que si el experimento fuera repetido todos los días en un mundo regido por el realismo local, un resultado como el obtenido debería obtenerse una vez en mil millones de años.

Miguel Larotonda, Profesor en UBA e Investigador en CITEDEF-CONICET: “Es un experimento que tiende a cerrar el abismo existente entre el público en general y los conceptos 'extraños' y anti-intuitivos de la mecánica cuántica, al atraer y motivar a participantes de todo el mundo para producir secuencias impredecibles de bits, que alimentan experimentos simultáneos y de última tecnología en una cantidad de laboratorios de todo el mundo. En Argentina, el experimento BBT generó un interés sin precedentes en los medios, en el periodismo científico en particular y en el público no especializado en general.”

Carlos Abellán, investigador en ICFO e impulsor del proyecto: “El BIG Bell Test fue un proyecto increíblemente desafiante y ambicioso. En el comienzo parecía de una dificultad imposible de sortear, pero se convirtió en una realidad gracias al esfuerzo de docenas de científicos entusiastas, comunicadores científicos, periodistas y distintos medios, y especialmente a las decenas de miles de personas que contribuyeron al experimento durante el 30 de Noviembre de 2016.”

Morgan Mitchell, líder del proyecto BBT y Profesor de la Insititució Catalana de Recerca I Estudis Avançats (ICREA) en el ICFO: “Para mí, lo más asombroso es que la discusión entre Einstein y Niels Bohr, después de más de 90 años de esfuerzos para plantearla de forma más rigurosa y estudiarla en forma experimental, aún conserva un componente humano y filosófico. Sabemos que el bosón de Higgs y las ondas gravitacionales existen gracias a máquinas sorprendentes, sistemas físicos construidos para poner a prueba las leyes de la física. Pero la del realismo local es una pregunta que no podemos contestar en forma completa usando una máquina. Pareciera que nosotros mismos debemos ser parte del experimento, para preservar la honestidad del Universo.”

El equipo del BIG Bell Test quiere agradecer una vez más a los miles de participantes que en forma tan entusiasta y generosa contribuyeron a esta iniciativa. Sin su aporte esencial, este experimento nunca habría sido posible. Referencia: Challenging local realism with human choices, The Big Bell Test Collaboration, Nature 2018.

https://www.nature.com/articles/s41586-018-0085-3

https://arxiv.org/abs/1805.04431

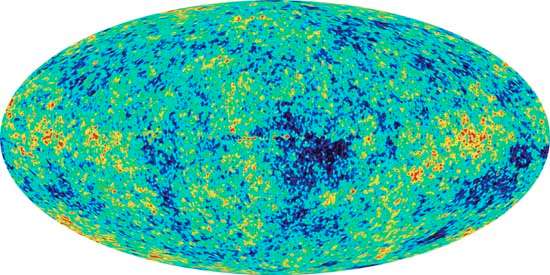

“La cosmología se parece a la paleontología en el sentido que estamos tratando de reconstruir la historia a partir de piezas que encontramos. Nosotros no excavamos la tierra sino que usamos telescopios para sacar fotos de cosas que están muy lejos y, como la luz tarda en llegar, sabemos que sucedieron mucho antes en la historia del universo”. El que habla es Matías Zaldarriaga, físico egresado del Departamento de Física, hoy profesor en Princeton y de visita en nuestro país.

La comunidad científica coincide en las evidencias y modelos acerca del origen del universo sólo hasta cierto momento de la historia: "tenemos consenso porque hay, por así decirlo, "fotos" a disposición, pero nos faltan datos de las primeras fracciones de segundo. Además, las leyes de la física que somos capaces de medir en los laboratorios no son válidas para esos instantes; por lo tanto el debate es mayor y aunque hubiera acuerdo en las interpretaciones podríamos no estar comprendiendo bien lo sucedido".

Una de esas “fotos” de la que habla Zaldarriaga es el mapa de temperatura que tenía el universo 380 mil años después de la expansión feroz que conocemos como Big Bang. Una imagen proporcionada por la radiación del fondo cósmico de microondas cuando la temperatura descendió lo suficiente como para permitir que los electrones y protones formen átomos de hidrógeno neutro, dejando paso libre a la radiación. Esos fotones que nos llegan poseen información sobre las condiciones físicas del universo de aquel momento y, de su viaje hasta hoy nos brindan información sobre la materia y la energía que posee el cosmos.

Entre los vestigios que observan los cosmólogos, hay gases livianos que atesoran mucha información: “Medimos cuánto helio y cuánto deuterio hay en el universo para contrastar esos datos con las predicciones hechas a partir de la física nuclear y las ecuaciones de la Relatividad General en relación a la expansión del universo de ese momento; sabemos que el modelo es correcto cuando representa a las reacciones nucleares que originaron a esos elementos”, explica el físico y agrega que “antes de los gases se generaron los neutrinos, y también fueron detectados los efectos de estas partículas en la radiación cósmica de fondo, además, conocemos con cierta certeza la época en que los neutrinos fueron producidos”.

Zaldarriaga cuenta que la época dorada de la cosmología fue entre 1940 y 1960 y que hoy se encuentran en “una etapa de precisión”. En este momento él y su equipo de trabajo desarrollan modelos para hacer predicciones más precisas sobre la estructura a gran escala del universo que llevarán a cabo las nuevas generaciones de telescopios.

Las preguntas abiertas siguen siendo “qué son la materia y la energía oscura, qué pasó en el principio, por qué el universo es tan grande, de dónde salieron las primeras fluctuaciones esenciales que luego dieron lugar a las galaxias, a la estructura a gran escala del universo, y a la radiación cósmica de fondo. Son preguntas que nos hacemos hace décadas y probablemente sigan con nosotros otras tantas”.

Se llevó a cabo un nuevo encuentro de física espacial de países latinoamericanos, esta vez en Buenos Aires. La reunión número once incluyó además una Escuela donde más de cincuenta jóvenes estudiantes pudieron tomar clases con los referentes internacionales del área.

Cada tres años la Asociación Latinoamericana de Geofísica Espacial (ALAGE) celebra el encuentro donde más de doscientos investigadores de la región comparten y debaten los resultados originales de sus investigaciones. Este año, los organizadores fueron un grupo de científicos argentinos expertos en el campo; entre ellos los profesores del Departamento de Física Daniel Gómez, Pablo Dmitruk, Cristina Mandrini y Sergio Dasso, y también investigadores del Instituto de Astronomía y Física del Espacio (IAFE) como César Bertucci y Marcelo López Fuentes; y de la UTN (Regional Mendoza) como Hebe Cremades.

“Durante el 16 al 20 de abril tuvo lugar el congreso, que llamamos COLAGE en el Centro Cultural de la Ciencia. Es la primera vez que se hace en Buenos Aires -la segunda en Argentina-, y para nosotros fue muy emocionante contar con la presencia de Juan Roederer como principal invitado. Roederer fue profesor del Departamento hasta la noche de los bastones largos, luego se exilió a Estados Unidos y reside allí desde entonces”, relata Gómez.

Además de su exposición sobre 60 años de Física del Cinturón de Radiación, el legendario físico tocó unas piezas de Nicolas de Grigny y de Bach en el órgano para todo el auditorio. Otro momento especial fue la entrega del premio “Mario Acuña” a dos investigadores de larga trayectoria; el galardón es en honor al físico argentino que desarrolló los magnetómetros utilizados en innumerables misiones espaciales y contribuyó además a la constitución de la ALAGE.

El profesor Daniel Gómez que además es investigador del IAFE, perteneciente a UBA-CONICET, considera que una “reunión de latinos es necesaria porque si bien todos nosotros mantenemos contactos con colegas en Europa o Estados Unidos, que es donde se hace ciencia de frontera y donde están los recursos, debemos mirarnos entre nosotros también. Nuestras realidades son parecidas, estos encuentros se hacen a pulmón pero son fundamentales”

Las ponencias fueron sobre sobre una diversidad de temas que incluyen el estudio del espacio alrededor de la Tierra, el medio interplanetario, las atmósferas de planetas y cometas, la variabilidad solar y su impacto en la Tierra. Así como se abordó la importancia que tiene la disciplina para la operación confiable de los sistemas espaciales y para una mejor comprensión de los procesos involucrados en el cambio climático global.

Por otro lado, se desarrolló la Escuela entre los días 23 y el 26 de abril en el aula Magna de nuestra institución, donde 54 estudiantes latinoamericanos de licenciatura, maestría y doctorado asistieron a clases intensivas con profesores de primer nivel. Especialistas en temas de relevancia actual como magnetósferas planetarias, aceleración de partículas y propagación de ondas de choque, turbulencia en el viento solar y clima espacial contribuyeron a la formación de los jóvenes científicos.

La Escuela fue financiada en buena parte por el Centro Latinoamericano de Formación Interdisciplinaria (CELFI), un programa dependiente del MinCyT. “Los congresos latinoamericanos se realizan cada tres años, lo que es un esfuerzo muy grande para una comunidad con pocos recursos. Por eso el apoyo del CELFI fue fundamental, permitió la participación de jóvenes y eso es apostar a la generación que viene. Le da vitalidad a esta comunidad, que trabaja en temas fundamentales, como la Física Espacial y su impacto sobre nuestro planeta”, afirma Gómez.

El profesor del DF repasa las investigaciones recientes de Juan Maldacena y colaboradores acerca de la relación entre mecánica cuántica y agujeros negros.

Uno de los resultados sobresalientes arrojados por la investigación en física teórica en los últimos cinco años ha sido la observación de una estrecha relación entre ciertos aspectos de la información cuántica y la geometría de los agujeros negros. Este es un descubrimiento tan sorprendente cuanto inesperado dado que viene a relacionar dos subdisciplinas que, hasta el momento, parecían pertenecer a esferas diferentes.

La conexión entre información cuántica y gravedad nace del intento de los físicos por tratar de resolver algunas paradojas desconcertantes a las que nos enfrenta el estudio de la evolución de los agujeros negros. Esta conexión se hace concreta en un trabajo de 2013, en el que Juan Maldacena y Leonard Susskind propusieron lo que hoy se conoce como “la correspondencia ER=EPR”, una críptica igualdad entre dos acrónimos que refieren a los nombres de tres célebres físicos: Einstein-Rosen (ER) y Einstein-Podolsky-Rosen (EPR). Pero, antes de explicar qué es la correspondencia ER=EPR, dediquemos unos párrafos a recordar de qué hablamos cuando hablamos de ER y EPR. Comencemos por lo segundo (EPR) dado que se trata de una noción más familiar.

Entrelazamiento cuántico y agujeros de gusano

Como decíamos, EPR refiere a Albert Einstein, Boris Podolsky y Nathan Rosen, quienes en 1935 escribieron un artículo1 en el que se hacían la pregunta de si “puede la descripción mecano-cuántica de la realidad ser considerada completa”. Como la mayoría de los artículos cuyos títulos cobijan una pregunta por sí o por no, la pretensión del trabajo de estos notables físicos era sugerir una respuesta negativa. Hoy, empero, hemos aprendido a vivir con un “sí” como respuesta. De todas formas, independientemente del error en el espíritu del trabajo original de Einstein y sus colaboradores, el aporte de éstos a la mecánica cuántica ha sido enorme, dado que evidenció la importancia del efecto que conocemos como “entrelazamiento cuántico” –un término acuñado ese mismo año por Erwin Schrödinger–.

El entrelazamiento cuántico es el fenómeno por el cual un conjunto de partículas puede encontrarse en un estado cuántico que no admite ser descripto por la mera agregación de los estados individuales de las partículas que lo forman. En otras palabras, cuando existe entrelazamiento la función de onda que describe el estado del sistema cuántico refiere inevitablemente al sistema como un todo inescindible, lo que expresa que los subsistemas (cada partícula) se encuentran “entrelazados”. En el caso de que el conjunto de partículas se compone de sólo dos de ellas, el sistema entrelazado recibe el nombre de “par EPR”. El ejemplo por antonomasia de un par EPR es el de dos partículas (llamémoslas A y B) que se envían a dos regiones, distante una de la otra. Debido al entrelazamiento de los estados que describen las dos partículas, la medición de una dada cantidad física de la partícula A que un laboratorista decidiera realizar determinará los resultados posibles de una medición ulterior que un segundo laboratorista, aunque distante del primero, fuera a realizar sobre la partícula B. Esto es, los resultados posibles de una medición realizada sobre B dependen del resultado de la medición realizada sobre A, y esto es así independientemente de si las dos partículas se encuentran a varios pársecs de distancia una de la otra. Esto, aunque a primera vista podría parecer como una acción a distancia, no entra en contradicción con ningún principio de la relatividad ni propiedad local de las leyes físicas. De hecho, este fenómeno, aunque inquietante, no puede ser empleado para transmitir información más rápido que la luz.

Pasemos ahora a describir el lado izquierdo de igualdad ER=EPR; hablemos de lo que Einstein y Rosen hacían cuando Podolsky no miraba: En un artículo del mismo año, 1935, Einstein y Rosen mostraron que las ecuaciones de la teoría de la relatividad general, que describen la gravedad como una deformación del espacio-tiempo, admiten soluciones que representan un escenario muy peculiar en el cual dos agujeros negros, en principio distantes, podrían estar conectados por un túnel interno; como si se tratara de una suerte de atajo en el espacio y el tiempo, un túnel del cual cada agujero negro es una boca de entrada2. Esto se conoce con el nombre de “puente de Einstein-Rosen” o también como “agujero de gusano”. A diferencia de los agujeros de gusano y pasajes espaciotemporales a los que nos tiene acostumbrados la ciencia-ficción, el puente de Einstein-Rosen no puede ser atravesado; es decir, uno no puede entrar por un lado y salir por el otro. Poder hacerlo requeriría la existencia de materia exótica de un tipo que no existe en nuestro universo –o la preponderancia de efectos cuánticos que son desdeñables para los propósitos del turismo espaciotemporal–. Debido a esta imposibilidad de ser atravesados, y al igual que ocurre con los pares EPR, los agujeros de gusano de ER no pueden ser empleados para transmitir información más rápido que la luz. Aun así, es interesante que, aunque no pueda uno entrar por un agujero negro en una galaxia y salir por un agujero negro de otra, la física sí permita que ambos agujeros negros compartan el mismo interior.

Como notamos, los pares EPR y los puentes ER son sistemas físicos quea priori pertenecen a reinos muy diferentes. Mientras los primeros nos hablan de las propiedades de entrelazamiento de las partículas, los segundos nos hablan del fabuloso bestiario de topologías que el espacio-tiempo puede adquirir a escalas astrofísicas. Ahora bien, aunque de reinos diferentes, reconocemos inmediatamente que EPR y ER comparten mucho más que dos autores y el año de publicación de los trabajos: Tanto EPR como ER nos cuentan de la interconectividad de sistemas distantes y de cómo esta conectividad se logra sin que atente contra el principio que dicta que no es posible enviar información más rápido que la luz. En este sentido ER y EPR se parecen mucho y cabe la pregunta de si hay, acaso, una conexión más directa entre ellos.

A esta pregunta parecen responder por la afirmativa Maldacena y Susskind en su artículo de 2013, tituladoHorizontes fríos para agujeros negros entrelazados, en el que arguyen que ER y EPR son dos efectos conectados o, de manera más sucinta, ER=EPR.

La conjetura ER = EPR

En su trabajo3, Maldacena y Susskind formulan dos conjeturas; la primera, menos especulativa que la segunda. Comienzan afirmando que dos agujeros negros que se encuentran separados por grandes distancias y cuyos interiores están conectados por un puente de ER pueden ser pensados como si se tratara de dos astros cuyos estados cuánticos están máximamente entrelazados. La segunda conjetura de estos dos renombrados físicos va más allá al proponer una versión recíproca de la afirmación anterior: todo par EPR en mecánica cuántica, aunque se trate éste de dos fotones entrelazados como los que se generan en laboratorios, tiene asociado un puente ER. Claramente esto último merece una aclaración ya que de ninguna manera podríamos acepar que cada vez que creamos un par EPR en nuestros laboratorios estamosipso facto abriendo túneles en el espacio-tiempo… ¿O acaso sí?

Pues bien, Maldacena y Susskind proponen que, en efecto, así es; pero ocurre que esos túneles espaciotemporales, esos puentes de ER que acompañan a cada par de partículas entrelazadas, han de ser microscópicos y de naturaleza cuántica, algo que, a falta de una teoría de la gravedad cuántica, aún no entendemos completamente.

Maldacena, junto a muchos otros colegas del área, se encuentra trabajando activamente en esta idea con el objetivo de hacer más precisa su formulación, entender sus implicancias y tratar de generalizarla. En relación con esto, recientemente hubo trabajos muy interesantes en los que se ahonda en la relación entre agujeros de gusano y procesos de información cuántica. Por ejemplo, el año pasado se logró entender cómo los protocolos de teleportación cuántica admiten una descripción dual en términos de señales que atraviesan agujeros de gusano –sumado esto a un canal clásico, como suele aparecer en las realizaciones de este tipo de procesos–. También es interesante la línea de investigación reciente que trata de relacionar la descripción geométrica de los agujeros de gusano con lo que se conoce como “red de tensores” y con estructuras matemáticas similares. Esta es un área de gran actividad a la que muchos físicos teóricos se dedican actualmente. Sin ir más lejos, hoy mismo Maldacena y Xiao-Liang Qi acaban de publicar en la base de datos arXiv un interesante trabajo en el que estudian agujeros de gusano que sí permiten ser atravesados y cómo los mismos admiten una descripción análoga en términos de sistemas simples de mecánica cuántica.

La pared de fuego en el horizonte de eventos

Una de las aplicaciones más importantes de la conjetura ER=EPR, y que fue en efecto la motivación original para que Maldacena y Susskind comenzaran a investigar el problema, es la resolución de lo que se conoce como “la paradoja de Almheiri-Marolf-Polchinski-Sully” (AMPS), también conocida como “la propuesta de la pared de fuego”. En 2012, Polchinski y sus colaboradores publicaron un trabajo4 en el que mostraban la incompatibilidad entre las siguientes tres propiedades físicas:a) la unitariedad de la evolución temporal de la teoría cuántica,b) el principio de equivalencia entre inercia y gravedad de la teoría de la relatividad, yc) la descripción de la naturaleza en términos de una teoría local de campos. Estas tres propiedades físicas, según afirmaban los autores del trabajo4 aduciendo sólidas razones, no pueden ser todas ciertas simultáneamente. Esto representa un serio problema ya que tanto el principio de unitariedad como el principio de equivalencia y la noción de campo son piezas paradigmáticas en las que se basa todo lo que entendemos en física. Si estos tres elementos constitutivos de nuestro corpus teórico son incompatibles, entonces debemos renunciar a uno de ellos al menos; pero ¿a cuál? ¿Por cuál de nuestros pilares predilectos elegir? ¿La unitariedad?, ¿la equivalencia?, ¿la localidad y los campos?

La respuesta de Polchinski y sus colaboradores fue tajante: De ninguna manera podemos descartar la unitariedad y lo que hemos aprendido de la cuántica; renunciemos, pues, al principio de equivalencia. Parecía la opción más lógica. Pero esto no se logra sin dolor: Abandonar el principio de equivalencia trae aparejados problemas conceptuales no menores. Por ejemplo, según este principio un observador en caída libre no puede experimentar nada que no sea equivalente a lo que experimenta un observador libre de fuerzas. En particular, un observador cayendo libremente hacia un agujero negro –lo suficientemente grande– no debería sentir nada especial al atravesar la superficie del astro, superficie que recibe el nombre de “horizonte de eventos”. Ahora bien, si AMPS están en lo cierto y el principio de equivalencia deja de ser válido en las inmediaciones de los agujeros negros, entonces uno debe aceptar que un observador en caída libre hacia el astro debería incinerarse al instante de atravesar el horizonte de eventos. A este fenómeno de incineración de la información entrante se lo conoce como “pared de fuego”.

El argumento preciso para abogar en favor de la pared de fuego involucra nociones de información cuántica, pero puede resumirse de manera sencilla así: Por un lado, los agujeros negros emiten una radiación térmica, tenue pero persistente. La unitariedad de la mecánica cuántica demanda que, para un agujero negro lo suficientemente viejo que haya ya transferido al medio interestelar al menos la mitad de su entropía, el estado cuántico que describe las partículas que componen dicha radiación debe estar entrelazado máximamente con el estado cuántico que describe la materia que le dio origen al astro. Por otro lado, el principio de equivalencia demanda que esa misma materia que formó el astro debe estar también en un estado cuántico máximamente entrelazado con aquel que describe lo que el agujero negro encierra en su interior. Pero en esto hay un serio problema ya la mecánica cuántica prohíbe esta poligamia de entrelazamientos: o bien el entrelazamiento se da con la radiación saliente o bien con la materia en el interior, pero no con ambos. Ergo, el principio de unitariedad y el principio de equivalencia no pueden ser ciertos al mismo tiempo. Alguno debe claudicar. Si el segundo de estos principios es el que deja de valer, entonces algo violento debe experimentar el observador que cruza el horizonte, algo que destruya el entrelazamiento –la información– con aquello que entra al agujero negro.

El argumento preciso para abogar en favor de la pared de fuego involucra nociones de información cuántica, pero puede resumirse de manera sencilla así: Por un lado, los agujeros negros emiten una radiación térmica, tenue pero persistente. La unitariedad de la mecánica cuántica demanda que, para un agujero negro lo suficientemente viejo que haya ya transferido al medio interestelar al menos la mitad de su entropía, el estado cuántico que describe las partículas que componen dicha radiación debe estar entrelazado máximamente con el estado cuántico que describe la materia que le dio origen al astro. Por otro lado, el principio de equivalencia demanda que esa misma materia que formó el astro debe estar también en un estado cuántico máximamente entrelazado con aquel que describe lo que el agujero negro encierra en su interior. Pero en esto hay un serio problema ya la mecánica cuántica prohíbe esta poligamia de entrelazamientos: o bien el entrelazamiento se da con la radiación saliente o bien con la materia en el interior, pero no con ambos. Ergo, el principio de unitariedad y el principio de equivalencia no pueden ser ciertos al mismo tiempo. Alguno debe claudicar. Si el segundo de estos principios es el que deja de valer, entonces algo violento debe experimentar el observador que cruza el horizonte, algo que destruya el entrelazamiento –la información– con aquello que entra al agujero negro.

Esta observación de AMPS desató un vehemente debate; en especial, entre 2012 y 2013. Ante la disyuntiva de si uno debía renunciar al principio de unitariedad o al principio de equivalencia, los físicos teóricos adoptaron distintas posiciones, la mayoría optando por aferrarse al primero de ellos. La conjetura de ER=EPR de Maldacena y Susskind vino a resolver el dilema y calmar las aguas. En efecto, hoy se yergue como una posible solución. Según ER=EPR, el argumento en favor de la pared de fuego encierra una falacia: En el experimento imaginario con el que se proponía exponer la contradicción entre el principio de unitariedad y el principio de equivalencia aparece la instancia de hacer mediciones sobre la radiación emitida por el agujero negro y cotejar los resultados de esas mediciones con otras llevadas a cabo por los observadores que cruzan la superficie del astro. Maldacena y Susskind aducen que esa medición sobre la radiación emitida por el agujero negro no es inocua sino que afecta lo que un observador que cruza el horizonte vaya a experimentar, de manera análoga a como la medición sobre la partícula A de un par EPR determina los posibles resultados de la medición efectuada sobre la partícula B. Esto puede ser interpretado como si existieran puentes de ER entre un agujero negro y las partículas que componen la radiación que él mismo emite. Así, si un observador lejano al agujero negro decide no realizar medición alguna sobre los quanta que componen la radiación emitida por el agujero negro, entonces un observador que cruzara el horizonte de eventos no sentiría nada especial al hacerlo; pero, si por el contrario el observador distante sí realizara una medición sobre la radiación emitida, entonces al hacerlo estaría enviando información a través de los micro-puentes ER que unen cada partícula de la radiación con el agujero negro que las emitió, y esto podría producir una pared de fuego en el interior del astro que terminaría por fulminar al atrevido viajero que desee entrar en él.

Los agujeros negros como hologramas

La exposición precisa de la conjetura ER=EPR requiere un conocimiento previo de los trabajos de Maldacena5,6, y en especial del que lo hizo famoso: la correspondencia AdS/CFT, enunciada en 1997. La correspondencia AdS/CFT nos permite estudiar la física de los agujeros negros y de la radiación que éstos emiten en términos de teorías de campos que “viven” en un espacio de una dimensión menor. Es decir, permite pensar a los agujeros negros en nuestro espacio-tiempo 4-dimensional en términos de una teoría 3-dimensional más sencilla, como si no fueran esos astros más que hologramas abstrusos cuya información se almacena en un sustrato de una dimensión menor a la del objeto representado.

La correspondencia AdS/CFT de Maldacena vino a darle sustancia a una idea que ya había sido planteada, aunque vagamente, por otros físicos teóricos antes que él, físicos entre los que se encuentra el mismo Susskind8. Esta idea paradigmática se conoce como “principio holográfico” y establece que el universo todo, con sus tres dimensiones espaciales y su dimensión temporal, puede ser representado por una teoría más simple con tan solo dos dimensiones espaciales –más el tiempo–. Si esto es cierto, todo lo que existe en nuestro universo, y en particular los agujeros negros que éste contiene, serían imágenes holográficas cuya información reside en un mundo de sólo dos dimensiones espaciales y regido por leyes más simples. El espacio-tiempo sería, así, una noción emergente.

En el marco de esta idea, Maldacena se planteó en 2001 la siguiente pregunta: Si todo sistema físico, y en especial aquellos que involucran agujeros negros, puede ser pensado holográficamente en términos de una teoría “dual” más sencilla, ¿cuál sería tal descripción dual en el caso de un puente6,7 de Einstein-Rosen?; es decir, ¿qué estado cuántico en la teoría dual le corresponde a lo que en nuestro espacio-tiempo es un par de agujeros negros conectados internamente? Maldacena mostró6 que la respuesta a esa pregunta involucra estados entrelazados, estrechamente relacionados con lo que sería un par EPR. Ese trabajo de Maldacena de 2001 fue el punto de partida de la línea de investigación que hoy culmina con la propuesta ER=EPR.

No hace muchos años, en colaboración con James Lindesay, el mismo Leonard Susskind publicó un libro de divulgación en el que se trata de explicar principio holográfico en un lenguaje accesible8. Su libro, tituladoUna introducción a los agujeros negros, información y la teoría de cuerdas: El universo holográfico, es recomendable. Evitando tecnicismos, Lindesay y Susskind logran contar la idea general acerca de cómo la física que ocurre cerca de los agujeros negros puede ser representada por sistemas físicos de menor dimensionalidad. El libro, empero, fue publicado nueve años antes que el artículo de Maldacena y Susskind sobre ER=EPR, por lo que esto último no está discutido allí. De todos modos, el artículo original3 sobre ER=EPR, publicado enFortschritte der Physik en 2013, tiene un estilo retórico amigable, abunda en argumentos heurísticos y requiere mínimos conocimientos teóricos previos, por lo que es la referencia aconsejable para aquellos interesados en entender por qué EPR=ER o, como algunos parafrasean jocosamente, por qué P=1.

Referencias

1 A. Einstein, B. Podolsky & N. Rosen, "Can quantum-mechanical description of physical reality be considered complete?", Phys. Rev. 47(10) (1935).

2 A. Einstein & N. Rosen, "The particle problem in the general theory of relativity", Phys. Rev. 48(73) (1935).

3 J. Maldacena & L. Susskind, “Cool horizons for entangled black holes”, Fortsch. Phys. 61 (2013) 781.

4 A. Almheiri, D. Marolf, J. Polchinski & J. Sully, “Black holes: complementarity of firewalls?”, JHEP 1302 (2013) 062.

5 J. Maldacena, “The Large N limit of superconformal field theories and supergravity”, Int. J. Theor. Phys. 38 (1999) 1113, Adv. Theor. Math. Phys. 2 (1998) 231.

6 J. Maldacena, “Eternal black holes in anti-de Sitter”, JHEP 0304 (2003) 021.

7 J. Maldacena & L. Maoz, “Wormholes in AdS”, JHEP 0402 (2004) 053.

8 L. Susskind, “The world as a hologram”, J. Math. Phys. 38 (1995) 6377.

9 L. Susskind & J. Lindesay, “An introduction to black holes, information and the string theory revolution: The Holographic Universe”, World Scientific Publishing (2005).

Gaston Giribet es investigador del Centro de Cosmología y Física de Partículas de New York University, Profesor del Departamento de Física FCEyN-UBA, Investigador Principal IFIBA-CONICET.

Juan Martín Maldacena ha sido premiado con la Medalla Lorentz, de La Real Academia de las Artes y Ciencias de los Países Bajos. El galardón es por las innovaciones que hizo en las últimas dos décadas a la física teórica. "No lo esperaba", dice pero asegura que este reconocimiento es además para todos sus colegas que trabajan en esta área de la física.